こんにちは、営業部の山崎です。

検索順位の急落に加え、Googleサーチコンソールで「robots.txtにアクセスできません」というエラーが出ると、パニックになりますよね。

設定を見直しても解決しない場合、実は「Googleの自動ペナルティ」が原因かもしれません。

今回、通常の対処法では解決しなかった方へ向けて、弊社が突き止めた原因と解決策をまとめました。

目次

サーチコンソールで「robots.txtにアクセスできません」と表示された

「検索順位が急に落ちた気がする……」

不安になってGoogleサーチコンソールを確認してみると、案の定パフォーマンスは右肩下がり。

「検索順位を戻すために、まずは再インデックスだ」と、はやる気持ちを抑えてサーチコンソールの管理画面に向き合いました。

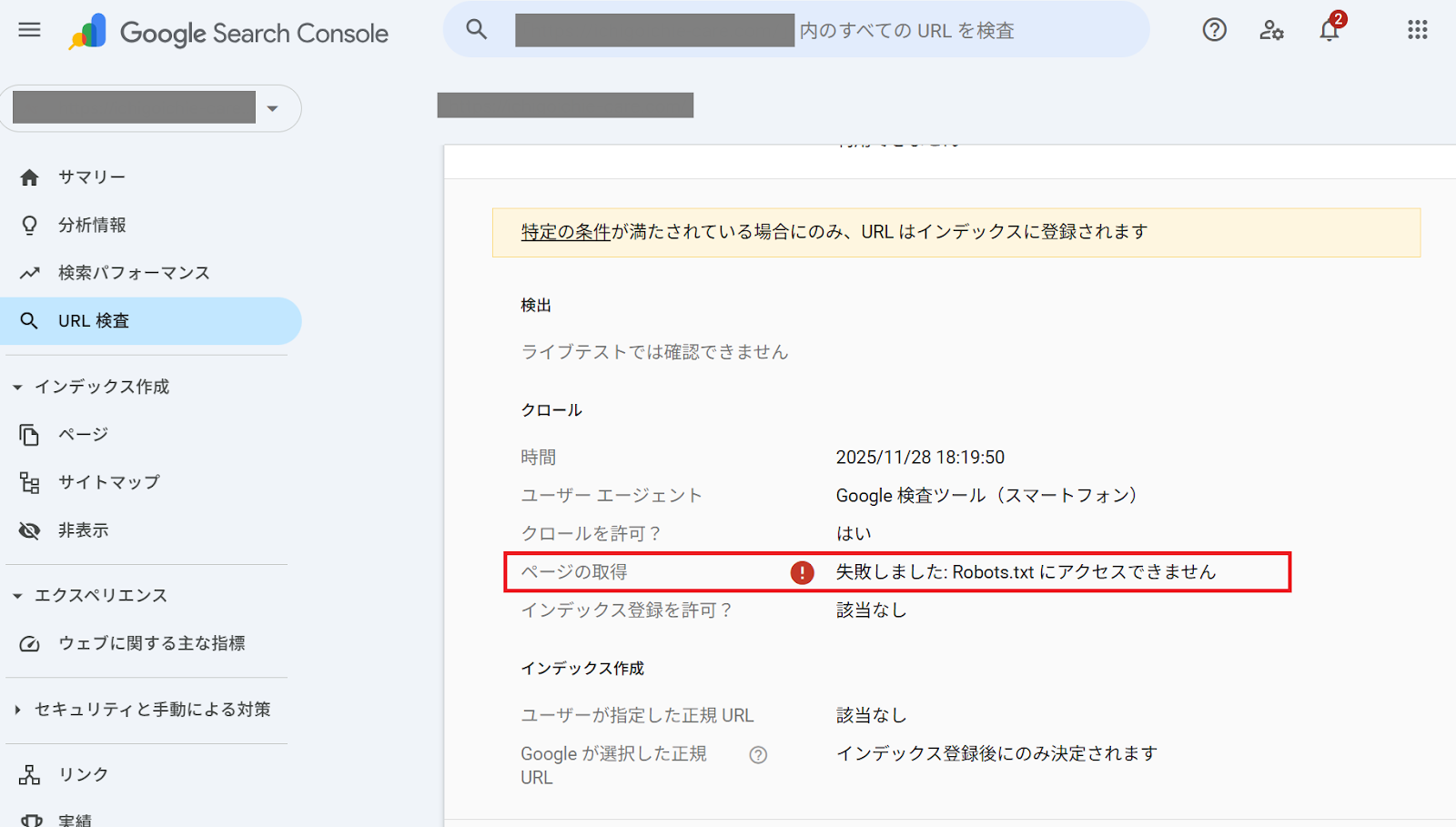

再リクエストを試みましたが、見慣れないエラーが…

さらに、sitemap.xmlを送っても「見つかりません」と表示される…

robots.txtもサイトマップも正しく設置しているはずなのに、なぜかGoogleが受け付けてくれない。実はこの現象、サイトの設定ミスではなく「Googleからの評価」が関係している可能性が高いのです。

まず確認すべき基本設定

エラーが出た際、まずは基本のチェックを行いましょう。

- sitemap.xmlの確認:サイトに不要なページ、リダイレクト済みのURL、重複URLが含まれていないか。

- robots.txtの記述:クローラーをブロックしない正しい記述になっているか。

「ここまでは全部やった。それでもエラーが消えない!」という方へ。ここからが本題です。

原因は「Googleの自動ペナルティ」によるアクセス制限?

弊社でも同様の事象が発生し、あらゆる技術的な修正を試しましたが解決しませんでした。しかし、試行錯誤の末にたどり着いた答えは意外なものでした。

「自動ペナルティを受けているサイトは、サーチコンソールでsitemap.xmlやrobots.txtすら拒絶されることがある」というものです。

記述ミスではなく、サイトそのものが「SEO的に問題がある(悪意がある)」と判定されてしまうと、Googleが情報を読み取りに来てくれない状態になっている可能性があるのです。

「Googleの自動ペナルティ」とは?

Googleのアルゴリズムが自動的に「低品質」や「スパム」と判定し、検索順位を下げる処置です。

サーチコンソールのメッセージ欄に通知が一切来ないのが厄介な点です。

自動ペナルティを解除し、サイト評価を改善するためのステップ

サイトがGoogleから「悪意がある」と疑われている場合、その原因を特定して排除する必要があります。

01.SEOチェックツールやAIで問題を洗い出す

自分では正常だと思っていても、クローラーの目(SEOの基準)で見るとNGな要素が含まれているかもしれません。

客観的に見直してみましょう。

- 信頼性の高いSEOチェックツールを使い、構文エラーやリンク切れ、表示速度の異常がないかを確認

- ChatGPTなどのAIに、サイトのコードやコンテンツをチェックしてもらう(効率が上がります!)

AIへの指示出し(プロンプト)のコツ

AIに相談するときは、できるだけ具体的な質問を投げるのがポイントです。

たとえば、

「以下のページ内容やHTML記述について、SEO観点でペナルティを受ける可能性のある問題点はありますか?」

「改善点をリストアップしてください」

といった形で指示すると、より精度の高い回答が得られます。

自分では気づきにくい隠しテキストのような記述や、過剰なキーワードの詰め込み、不適切なタグ設定など、SEO上のリスクを洗い出すきっかけにもなります。

02.SEOの問題を根本解決する

洗い出した問題点を一つずつ修正しましょう。

改善後の変化:インデックス復旧と順位回復までにかかる期間

SEOの問題を修正したあと、再度サーチコンソールを確認してみてください。

自動ペナルティが解除されると、拒絶されていたrobots.txtやsitemap.xmlが正常に読み込まれるようになり、順位も戻り始めます。

復旧までの期間は、一般的には1~2ヶ月かかると言われることもありますが、弊社のケースでは対応完了後1~2日ですぐに解消されました。

適切に原因を特定し、正しく修正を行えば、想像以上に早く解決する場合もあります。

まとめ

「robots.txtにアクセスできません」というエラーは、Googleからの「お宅のサイト、今のままだと怖くて入れません」というサインかもしれません。

設定ファイル(XMLやTXT)の書き直しだけで解決しない場合は、一度サイト全体のSEO品質を疑ってみてください。

「検索順位が急に下がったけど、どう対応していいか分からない…」

そんな時も、ひとりで悩まずにお気軽にお声がけください。

状況を丁寧に紐解き、解決への道筋を一緒に見つけます。

シーエムエーではサイトのお悩みについてのご相談を承っております。

おすすめの記事

おすすめタグ

- 広告

- ワイヤーフレーム

- 保護されていない通信

- XMLサイトマップ

- モダンブラウザ

- gulp.js

- Adobe Express

- AdobeExpress

- Edits

- 構造化マークアップ

- Google for jobs

- Transport Layer Security

- shopify

- gap

- node.js

- Webマーケティング

- Canva

- HTML5広告

- Googleしごと検索

- HowTo

- ECサイト

- gridレイアウト

- WebP画像

- デジタルマーケティング

- 画像作成

- Google Chrome

- 撮影

- ハウツー

- ショッピングサイト

- object-fit

- 楽天GOLD

- 文字コード

- ChatGPT

- videoタグ

- iPad

- 構造化データ

- ショッピファイ

- aspect-ratio

- スマートフォン用新店舗トップページ

- 符号化文字集合

- 業務効率化

- 動画

- 一眼レフカメラ

- リッチリザルト

- Shopify使い方

- any-hover

- Threads(スレッズ)

- Unicode(ユニコード)

- SNS

- 動画広告

- 写真

- ノンデザイナー

- WebP

- docker

- 未経験

- AdobeMAX

- GoogleMapsPlatform

- リモート

- 文字

- wordpress

- Photoshop

- Adobe Firefly

- 新人デザイナー

- AdobeFirefly

- スピードアップデート

- ウェブサイト翻訳

- デザイン

- リモートワーク

- クラウドドキュメント

- 画像生成AI

- CMS

- バリアブルフォント

- PageSpeed Insights

- iPhone

- フォント

- remotework

- ディスプレイ広告

- 生成塗りつぶし

- 絞り込み検索

- 生成AI

- SSL

- Facebook Audience Network

- Core Web Vitals

- ECcube

- スマートオブジェクト

- 生成拡張

- カレンダー

- Gemini

- HTML

- Zapier

- Facebook広告

- 自作PC

- プラグイン

- 画質パラメーター

- Adobe MAX Japan 2023

- ハッシュタグ

- Figma Slides

- PHP

- Google my map

- Instagram広告

- 初心者

- カスタマイズ

- サイズパラメーター

- UI

- 中小企業SFA

- PowerPoint

- CSS

- 創業記念日

- クリック率

- 自作パソコン

- ASP

- レクタングルバナー

- UX

- SFA

- Figmaデザイン

- 動画制作

- レクリエーション

- TLS

- PC組み立て

- IE

- アセット生成

- Adobe Stock

- 中小企業向けSFA

- グリッドビュー

- AMP

- Adobe XD

- Chrome

- Google Search Console

- コーディング

- タスクランナー

- アンチックフォント

- AVIF

- バージョン管理